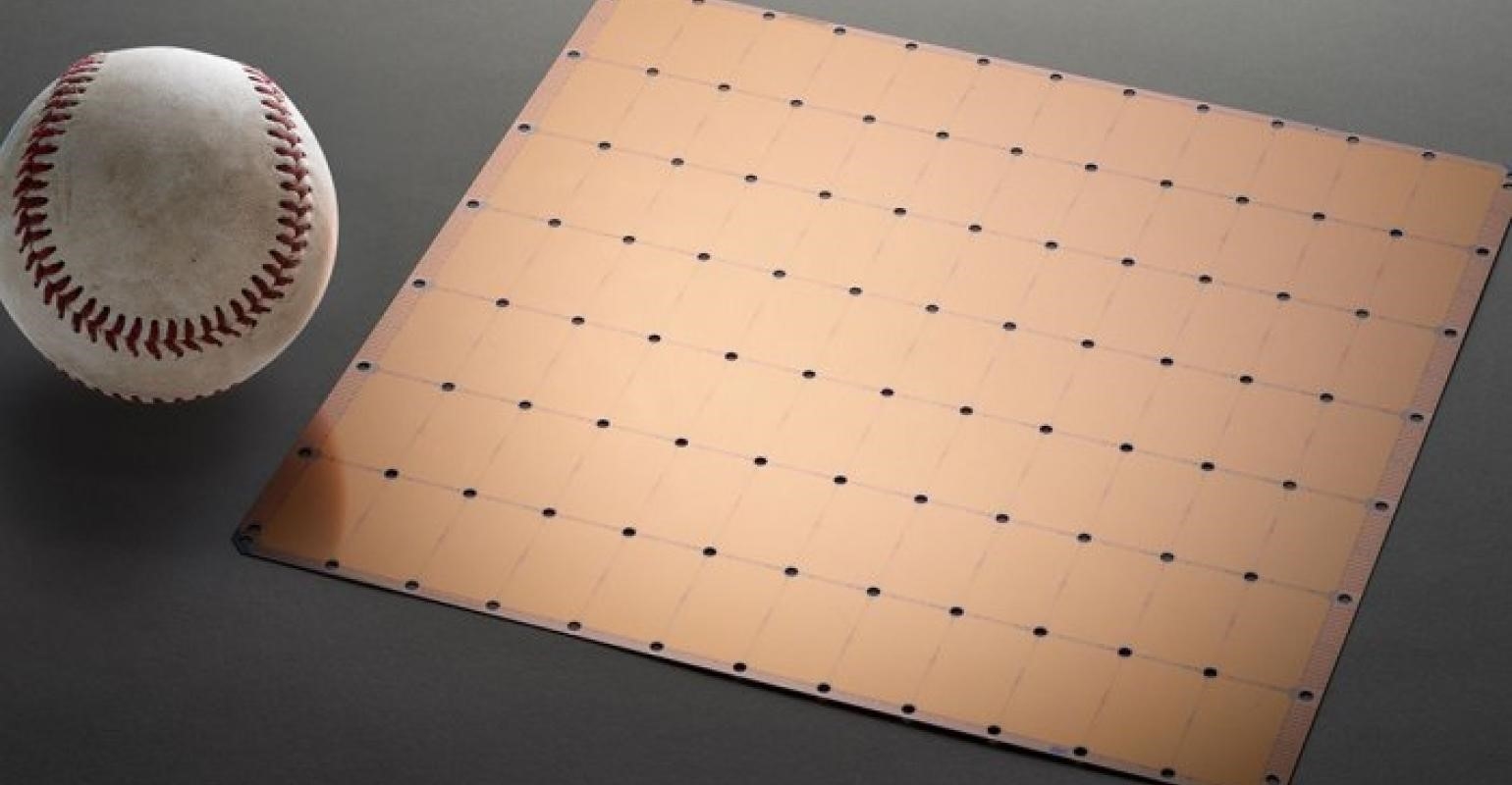

近日,世界知名加速器晶片公司 Cerebras 宣佈,他們已利用「巨型晶片」為 AI 訓練踏上了重要的一步,訓練出了單晶片最大的 NLP (自然語言處理) AI 模型,而這個模型具有 20 億個參數。

這塊全世界最大的加速器晶片採用 7nm 製程,由一整塊方形的晶圓刻蝕而成。其大小約為主流晶片的數百倍,具有 15KW 的功率,整合了 2.6 萬億個 7nm 電晶體,封裝了 850,000 個內核和 40 GB 記憶體。

NLP 模型的開發是 AI 中一個重要領域。利用 NLP 模型,AI 可以「理解」文字含義,並進行相應動作。OpenAI 的 DALL.E 模型就是一個典型的 NLP 模型。其可以將使用者的輸入的文字資料轉化為圖片輸出。比如輸入「牛油果形狀的扶手椅」後,AI 就會自動生成若干與這句話對應的圖像。而 Cerebras 開發的 NLP 還有一個巨大的突破,就是降低了 NLP 模型的開發難度。

Cerebras 表示,NLP 模型訓練與開發須要大量資源和專業知識,對於 AI 行業中的其他公司而言,NLP 訓練實在太昂貴、太耗時且無法使用。但若果單晶片就能夠支援 20 億個參數的模型,即意味著不需要使用海量的 GPU 分散訓練模型的工作量,可為廠商節省數千個 GPU 的訓練成本和相關硬件,同時這也使廠商不必經歷切分模型並將其工作負載分配給數千個 GPU 的痛苦。

而 Cerebras 能在參數量上取得爆炸式增長,是因為利用了權重流技術,可將運算與記憶體的佔用量分配,並允許將記憶體擴展到足以存儲 AI 工作負載中增加任何數量的參數。由於這項突破出現,設置模型的時間從幾個月減少到了幾分鐘,且開發者在 GPT-J 和 GPT-Neo 等型號之間「只需幾次按鍵」就可以完成切換,這讓 NLP 的開發變得更簡單。